Понятный робот — первый шаг к доверию: как ученые научили робота объяснять свои действия

По большей части роботы являются загадкой для конечных пользователей. И это вполне ожидаемо: в большинстве своем роботы являются автономными, и их цель — делать свое дело и не беспокоить вас. Но эта идея перестает действовать, когда люди начинают работать с роботами более тесно в совместных задачах. Нам трудно доверять им, если их автономия такова, что они не объясняют нам, что они делают в каждый конкретный момент.

В статье, опубликованной в Science Robotics, исследователи из Калифорнийского университета разработали роботизированную систему, которая может генерировать различные виды понятных для человека объяснений своих действий в реальном времени, а затем провели тестирование, чтобы выяснить, какие из объяснений были наиболее эффективными для повышения доверия человека к системе. Означает ли это, что теперь мы можем полностью понять и доверять роботам? Пока нет, но это только начало.

Эта работа финансировалась программой DARPA Explainable AI (XAI), цель которой — «понять контекст и среду, в которой роботы работают, и со временем создать базовые объяснительные модели, позволяющие им характеризовать явления реального мира». Согласно DARPA, «объяснимый ИИ — особенно объяснимое машинное обучение — имеет важное значение, чтобы [люди] могли понимать, надлежащим образом доверять и эффективно управлять новым поколением интеллектуальных партнеров-машин».

Есть несколько различных проблем, которые XAI должен решить. Одной из них является внутренняя непрозрачность моделей машинного обучения, когда вы вбрасываете большую кучу обучающих данных в какую-то сеть, которая затем большую часть времени выполняет то, что вы хотите, но также иногда выдает странные неправильные результаты, которые очень трудно понять или предсказать. Вторая проблема — выяснить, как системы с ИИ могут эффективно сообщать людям о том, что они делают, через то, что DARPA называет интерфейсом объяснения. Это как раз то, над чем работают ученые из Калифорнийского университета.

Робот Baxter, созданный в Калифорнийском университете, научился открывать бутылочку с лекарством, оснащенную специальным защитным колпачком, делающим процесс открытия сложным для детей (и роботов). Для этого он составил для себя тактильную модель, изучив то, как люди манипулировали с бутылочкой, предварительно надев специальную сенсорную перчатку. Это обучение объединили с символическим планировщиком действий, который позволяет роботу корректировать свои действия, дабы он мог приспособиться к бутылкам с различными типами крышек.

Интеграция символического планировщика и тактильной модели позволяет роботу спросить себя: «на основе человеческой демонстрации, формы бутылочки и прикладываемой мною силы, а также последовательности действий, которую я выполнил до сих пор, какое следующее действие имеет наибольшую вероятность для открытия бутылки?»

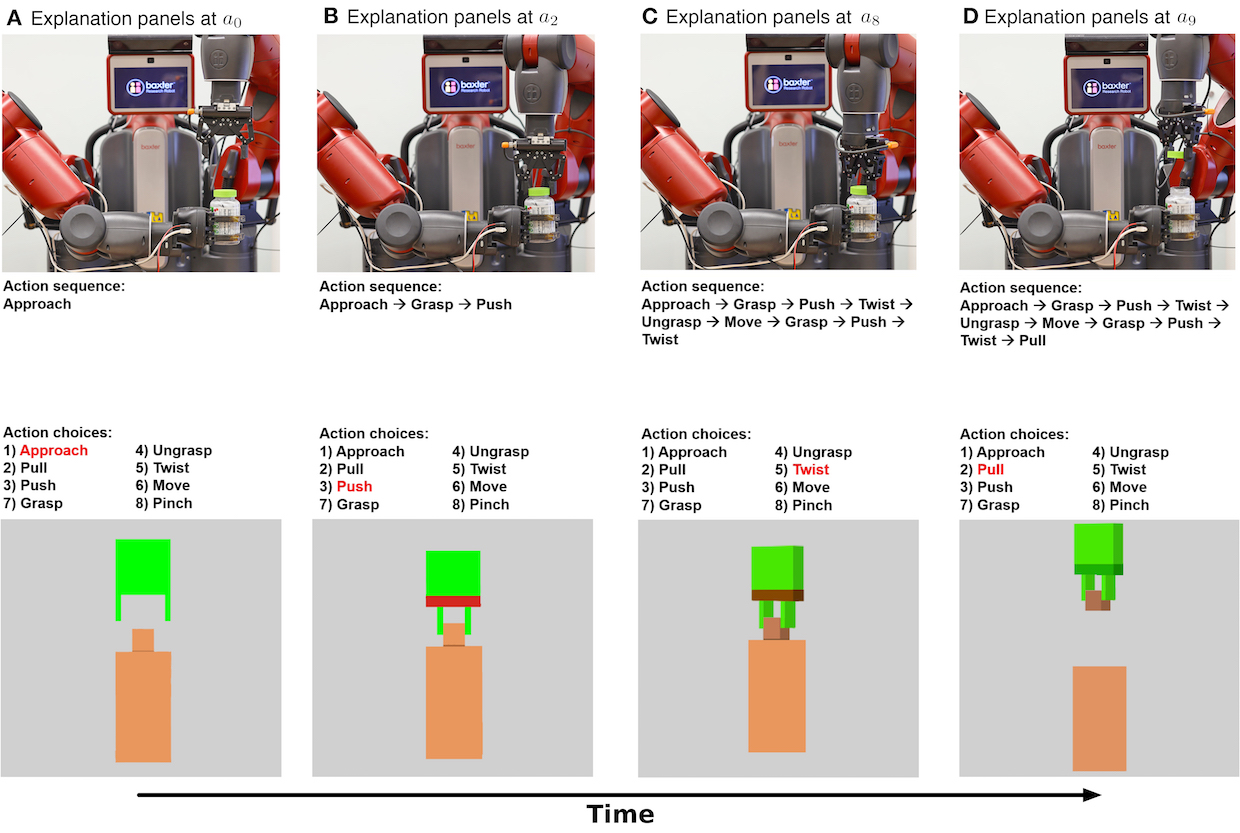

Как тактильная модель, так и символический планировщик могут быть использованы для показа понятных людям объяснений того, что делает робот. Тактильная модель может визуально показать каждое действие, которое выполняет робот, в то время как символический планировщик выводит последовательность действий, которые (в идеале) ведут к цели.

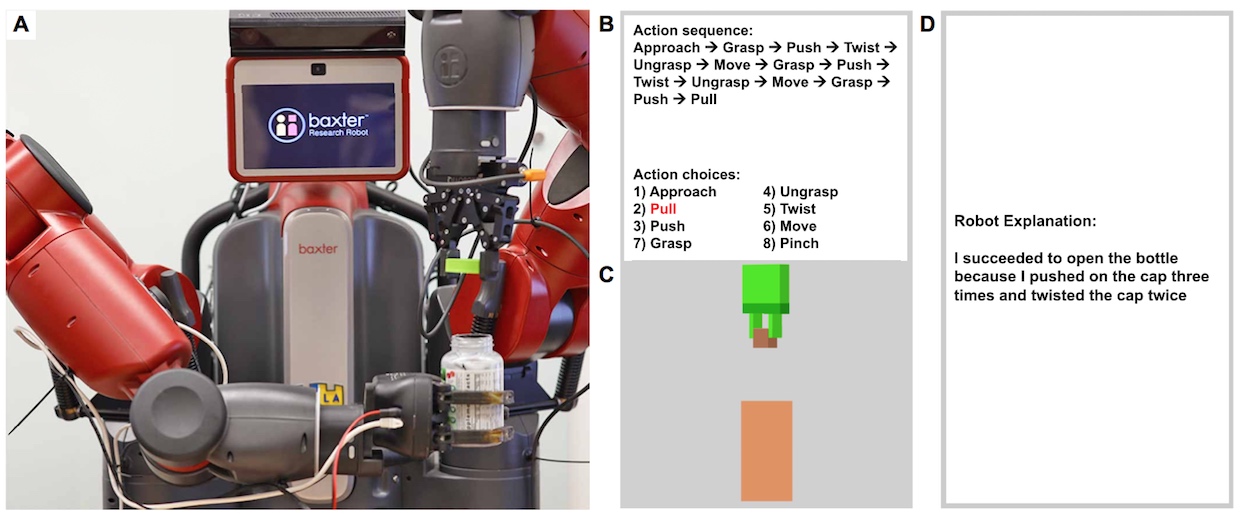

Чтобы выяснить, повлияли ли эти объяснения на уровень доверия или уверенности человека в том, что робот успешно справляется со своей задачей, исследователи провели психологическое исследование с участием 150 участников. Во время просмотра видео с роботом, открывающим флакон с лекарством, группам участников показывали тактильный планировщик, символический планировщик или оба планировщика одновременно, в то время как двум другим группам либо вообще не показывали никаких объяснений, либо показывали созданное человеком краткое изложение того, что делает робот. Результаты опроса показали, что самый высокий рейтинг доверия был получен от группы, которая имела доступ как к символическим, так и к тактильным объяснениям, при этом символическое объяснение было эффективнее тактильного.

Когда робот выполняет набор действий (верхний ряд изображений), его символический планировщик (средний ряд) и тактильная модель (нижний ряд) генерируют объяснения для каждого действия. Красный цвет манипулятора указывает на большую величину силы, приложенной захватом, а зеленый — на отсутствие силы. Эти объяснения предоставляются в режиме реального времени, когда робот выполняет действия.

В целом, людям, по-видимому, нужны символические объяснения внутренних решений робота в реальном времени для последовательностей выполняемых им действий, чтобы доверять машинам, выполняющим многоэтапные сложные задачи. Тактильная информация в этом плане менее понятна и наглядна. Чтобы люди могли доверять роботам и предсказывать их поведение, нужно, чтобы эффективное объяснение имело символическую интерпретацию и поддерживало тесную временную связь между объяснением и непосредственным поведением робота.

Однако само слово «объяснить» может иметь очень специфические интерпретации. Робот может объяснить, что он делает (то есть, какие шаги он предпринимает), таким образом, мы можем его понять. Однако на самом деле робот объясняет, «что» он делает, а не «почему», так как, по крайней мере, чаще всего ответ на вопрос «почему» (в представлении робота) таков: «потому что человек сделал это таким образом, а я у него научился».

И хотя в итоге ответ на вопрос, «что» делает робот, способствует развитию большего доверия людей, в долгосрочной перспективе XAI необходимо будет также научить роботов отвечать на вопрос «почему»: например, робот откручивает крышечку от бутылки потому, что ребенку пора принимать лекарство.

Вы можете видеть, что в этом успешном открытии бутылки есть несколько повторяющихся шагов, но, как наблюдатель, вы не можете знать, повторяет ли робот действие снова, потому что первое такое действие провалилось, или первое действие было только частью его плана. Может быть, открытие бутылки на самом деле занимает всего одну последовательность захвата-поворота, но манипулятор робота соскользнул в первый раз.

Понимание того, о чем «думает» робот, или, по крайней мере, обоснование его действий или бездействий, значительно увеличит человеческую уверенность в отношении роботизированных систем, потому что последние перестанут выглядеть такими… глупыми. Например, вот этот робот просто сидит и ничего не делает, потому что он сломан, или потому, что он просчитывает сложное запланированное движение? Этот умный пылесос ездит случайно, потому что он потерялся, или он катается псевдослучайно, потому что это самый эффективный способ очистки?

В своем психологическом эксперименте исследователи показали участникам видео с роботом, открывающим бутылку (A). Различные группы видели различные панели объяснений вместе с видео: панель символического объяснения (B); панель тактильного объяснения (C); панель текстового объяснения, составленного человеком (D).

Даже если робот принимает решение, с которым человек бы не согласился, ответ машины на вопрос «почему» покажет, что робот скорее всего не сломан, а просто столкнулся с ситуацией, на работу с которой он не был запрограммирован. И, опять же, отсутствие ответа на этот вопрос покажет, что у робота BSOD и его нужно чинить.

В долгосрочной перспективе исследователи из Калифорнийского университета работают над реализацией «почему», но в сообществе робототехники потребуется серьезный сдвиг, чтобы даже «что» стало приоритетом для дальнейшей разработки роботов. Основная проблема заключается в том, что инженеры сейчас в целом неуклонно сосредоточены на оптимизации производительности — кого волнует, что происходит внутри этого черного ящика, если он может успешно решать поставленные перед ним задачи в 99,9% случаев?

Но, по словам ведущего автора новой статьи Марка Эдмондса, даже такой подход не убирает нужду в объяснении действий робота. «Даже если вы достигли высокой производительности, кто вам сказал, что объяснение действий робота не позволит вам поднять производительность еще выше?», — говорит он. «Цель XAI в целом не состоит в том, чтобы побудить людей перестать идти по пути, ориентированному на производительность, но вместо этого стоит сделать шаг назад и спросить себя: «Что на самом деле делает эта система, и как мы можем заставить ее рассказать об этом нам?»

Согласитесь, немного страшно иметь системы (особенно критичные для безопасности), которые работают только потому, что они работают — потому что им надавали тонну обучающих данных и, в итоге, они, похоже, вроде бы делают то, что вам нужно. Но у вас есть только самые смутные идеи, почему эти системы работают, и, поскольку роботы и ИИ становятся все более заметной частью нашего общества, объяснимость станет критическим фактором, позволяющим нам с уверенностью доверять им.